はじめに

深層学習day1の「Section5:誤差逆伝播法」の実装演習を以下にまとめる。

実装演習

実装演習には、mnistのサンプルコードを使った。

# 自分の環境で、ダウンロードした共通関数の格納フォルダのパス

import sys

sys.path.append('DNN_code_colab_lesson_1_2')

import numpy as np

from data.mnist import load_mnist

import pickle

from common import functions

import matplotlib.pyplot as plt

# mnistをロード

(x_train, d_train), (x_test, d_test) = load_mnist(normalize=True, one_hot_label=True)

train_size = len(x_train)

print("データ読み込み完了")

# 重み初期値補正係数

wieght_init = 0.01 # 変更してみよう

#入力層サイズ

input_layer_size = 784 # 変更してみよう

#中間層サイズ

hidden_layer_size = 40 # 変更してみよう

#出力層サイズ

output_layer_size = 10 # 変更してみよう

# 繰り返し数

iters_num = 1000 # 変更してみよう

# ミニバッチサイズ

batch_size = 100 # 変更してみよ

# 学習率

learning_rate = 0.1 # 変更してみよう

# 描写頻度

plot_interval=10

# 初期設定

def init_network():

network = {}

network['W1'] = wieght_init * np.random.randn(input_layer_size, hidden_layer_size)

network['W2'] = wieght_init * np.random.randn(hidden_layer_size, output_layer_size)

# 試してみよう_Xavierの初期値

# network['W1'] = np.random.randn(input_layer_size, hidden_layer_size) / np.sqrt(input_layer_size)

# network['W2'] = np.random.randn(hidden_layer_size, output_layer_size) / np.sqrt(hidden_layer_size)

# 試してみよう Heの初期値

# network['W1'] = np.random.randn(input_layer_size, hidden_layer_size) / np.sqrt(input_layer_size) * np.sqrt(2)

# network['W2'] = np.random.randn(hidden_layer_size, output_layer_size) / np.sqrt(hidden_layer_size) * np.sqrt(2)

network['b1'] = np.zeros(hidden_layer_size)

network['b2'] = np.zeros(output_layer_size)

return network

# 順伝播

def forward(network, x):

W1, W2 = network['W1'], network['W2']

b1, b2 = network['b1'], network['b2']

u1 = np.dot(x, W1) + b1

z1 = functions.relu(u1)

u2 = np.dot(z1, W2) + b2

y = functions.softmax(u2)

return z1, y

# 誤差逆伝播

def backward(x, d, z1, y):

grad = {}

W1, W2 = network['W1'], network['W2']

b1, b2 = network['b1'], network['b2']

# 出力層でのデルタ

delta2 = functions.d_softmax_with_loss(d, y)

# b2の勾配

grad['b2'] = np.sum(delta2, axis=0)

# W2の勾配

grad['W2'] = np.dot(z1.T, delta2)

# 1層でのデルタ

delta1 = np.dot(delta2, W2.T) * functions.d_relu(z1)

# b1の勾配

grad['b1'] = np.sum(delta1, axis=0)

# W1の勾配

grad['W1'] = np.dot(x.T, delta1)

return grad

# 時間測定のため追加

import time

# パラメータの初期化

network = init_network()

accuracies_train = []

accuracies_test = []

# 正答率

def accuracy(x, d):

z1, y = forward(network, x)

y = np.argmax(y, axis=1)

if d.ndim != 1 : d = np.argmax(d, axis=1)

accuracy = np.sum(y == d) / float(x.shape[0])

return accuracy

# 開始時間

time_start =time.time()

time.sleep(1)

for i in range(iters_num):

# ランダムにバッチを取得

batch_mask = np.random.choice(train_size, batch_size)

# ミニバッチに対応する教師訓練画像データを取得

x_batch = x_train[batch_mask]

# ミニバッチに対応する訓練正解ラベルデータを取得する

d_batch = d_train[batch_mask]

z1, y = forward(network, x_batch)

grad = backward(x_batch, d_batch, z1, y)

if (i+1)%plot_interval==0:

accr_test = accuracy(x_test, d_test)

accuracies_test.append(accr_test)

accr_train = accuracy(x_batch, d_batch)

accuracies_train.append(accr_train)

print('Generation: ' + str(i+1) + '. 正答率(トレーニング) = ' + str(accr_train))

print(' : ' + str(i+1) + '. 正答率(テスト) = ' + str(accr_test))

# パラメータに勾配適用

for key in ('W1', 'W2', 'b1', 'b2'):

network[key] -= learning_rate * grad[key]

# 終了時間

time_end = time.time()

# 経過時間をプリント

time_lap = time_end - time_start

print("経過時間 = ",time_lap)

lists = range(0, iters_num, plot_interval)

plt.plot(lists, accuracies_train, label="training set")

plt.plot(lists, accuracies_test, label="test set")

plt.legend(loc="lower right")

plt.title("Accuracies")

# グラフの表示

plt.show()

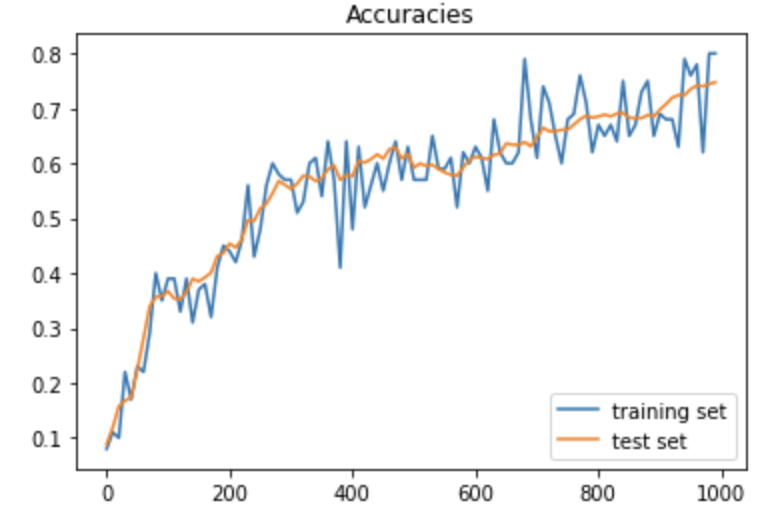

テストデータでの正答率は、ほぼ92%となった。また経過時間は、7.80秒であった。

ソースコード中の学習率(Learning_rate)を0.1から1.0、10.0、更に0.01に変更してみた。

経過時間については、学習率を大きすると処理が速くなる傾向はあるが、今回の測定範囲では、明らかな差とはならなかった。

| 学習率 | 0.01 | 0.1 | 1 | 10 |

|---|---|---|---|---|

| 経過時間(秒) | 7.85 | 7.80 | 7.68 | 7.61 |

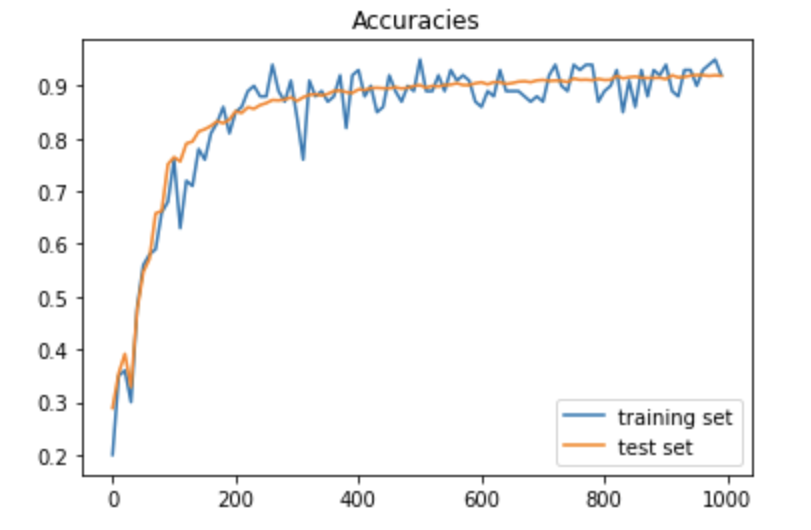

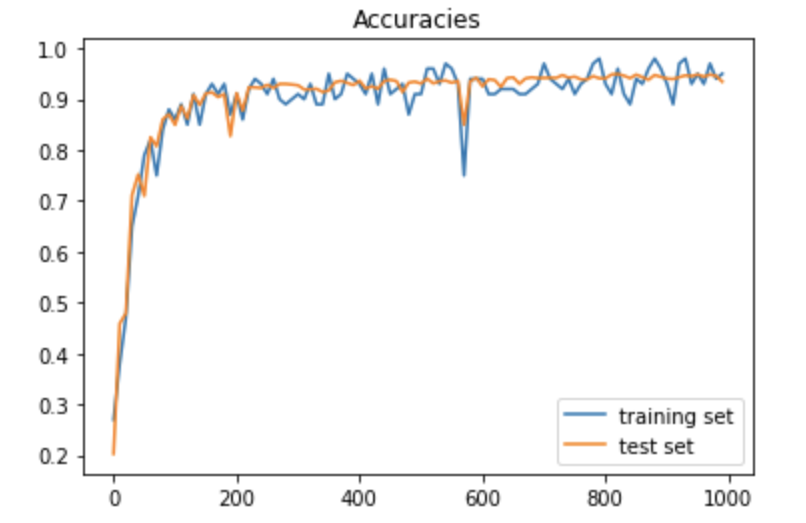

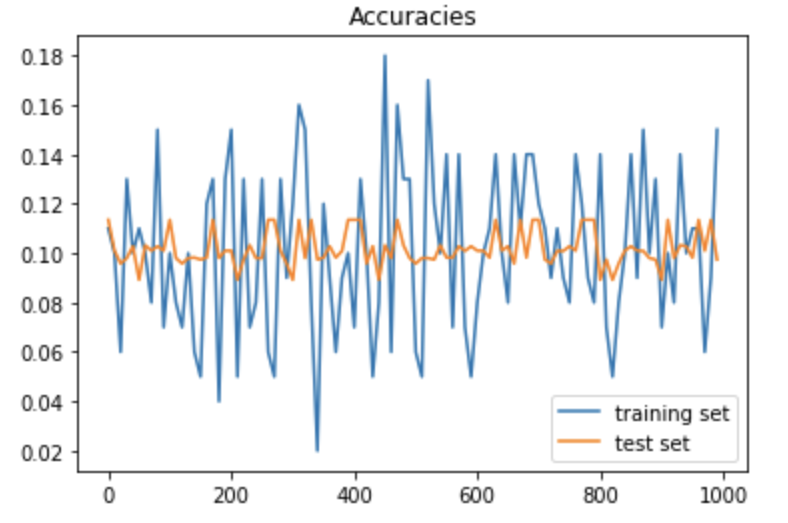

一方、成果率のグラフについては、次の通りで、学習率が10になると収束していないように見える。また、学習率が0.01では、収束までにさらに回数を回す必要がありそうである。

「学習率 =1」の時の正答率グラフ

「学習率 =10」の時の正答率グラフ

「学習率 =0.01」の時の正答率グラフ