はじめに

深層学習day2の「Section1:バッチ正規化」の実装演習を以下にまとめる。

実装演習

「2_3_batch_normalizaion.ipynb」のコードを参照した。

# 自分の環境で、ダウンロードした共通関数の格納フォルダのパス

import sys

sys.path.append('DNN_code_colab_lesson_1_2')

sys.path.append('DNN_code_colab_lesson_1_2/lesson_2')

import numpy as np

from collections import OrderedDict

from common import layers

from data.mnist import load_mnist

import matplotlib.pyplot as plt

from multi_layer_net import MultiLayerNet

from common import optimizer

# バッチ正則化 layer

class BatchNormalization:

'''

gamma: スケール係数

beta: オフセット

momentum: 慣性

running_mean: テスト時に使用する平均

running_var: テスト時に使用する分散

'''

def __init__(self, gamma, beta, momentum=0.9, running_mean=None, running_var=None):

self.gamma = gamma

self.beta = beta

self.momentum = momentum

self.input_shape = None

self.running_mean = running_mean

self.running_var = running_var

# backward時に使用する中間データ

self.batch_size = None

self.xc = None

self.std = None

self.dgamma = None

self.dbeta = None

def forward(self, x, train_flg=True):

if self.running_mean is None:

N, D = x.shape

self.running_mean = np.zeros(D)

self.running_var = np.zeros(D)

if train_flg:

mu = x.mean(axis=0) # 平均

xc = x - mu # xをセンタリング

var = np.mean(xc**2, axis=0) # 分散

std = np.sqrt(var + 10e-7) # スケーリング

xn = xc / std

self.batch_size = x.shape[0]

self.xc = xc

self.xn = xn

self.std = std

self.running_mean = self.momentum * self.running_mean + (1-self.momentum) * mu # 平均値の加重平均

self.running_var = self.momentum * self.running_var + (1-self.momentum) * var #分散値の加重平均

else:

xc = x - self.running_mean

xn = xc / ((np.sqrt(self.running_var + 10e-7)))

out = self.gamma * xn + self.beta

return out

def backward(self, dout):

dbeta = dout.sum(axis=0)

dgamma = np.sum(self.xn * dout, axis=0)

dxn = self.gamma * dout

dxc = dxn / self.std

dstd = -np.sum((dxn * self.xc) / (self.std * self.std), axis=0)

dvar = 0.5 * dstd / self.std

dxc += (2.0 / self.batch_size) * self.xc * dvar

dmu = np.sum(dxc, axis=0)

dx = dxc - dmu / self.batch_size

self.dgamma = dgamma

self.dbeta = dbeta

return dx

(x_train, d_train), (x_test, d_test) = load_mnist(normalize=True)

print("データ読み込み完了")

# batch_normalizationの設定 =======================

use_batchnorm = True

# use_batchnorm = False

# ====================================================

network = MultiLayerNet(input_size=784, hidden_size_list=[40, 20], output_size=10,

activation='sigmoid', weight_init_std='Xavier', use_batchnorm=use_batchnorm)

iters_num = 1000

train_size = x_train.shape[0]

batch_size = 100

learning_rate=0.01

train_loss_list = []

accuracies_train = []

accuracies_test = []

plot_interval=10

for i in range(iters_num):

batch_mask = np.random.choice(train_size, batch_size)

x_batch = x_train[batch_mask]

d_batch = d_train[batch_mask]

grad = network.gradient(x_batch, d_batch)

for key in ('W1', 'W2', 'W3', 'b1', 'b2', 'b3'):

network.params[key] -= learning_rate * grad[key]

loss = network.loss(x_batch, d_batch)

train_loss_list.append(loss)

if (i + 1) % plot_interval == 0:

accr_test = network.accuracy(x_test, d_test)

accuracies_test.append(accr_test)

accr_train = network.accuracy(x_batch, d_batch)

accuracies_train.append(accr_train)

print('Generation: ' + str(i+1) + '. 正答率(トレーニング) = ' + str(accr_train))

print(' : ' + str(i+1) + '. 正答率(テスト) = ' + str(accr_test))

lists = range(0, iters_num, plot_interval)

plt.plot(lists, accuracies_train, label="training set")

plt.plot(lists, accuracies_test, label="test set")

plt.legend(loc="lower right")

plt.title("accuracy")

plt.xlabel("count")

plt.ylabel("accuracy")

plt.ylim(0, 1.0)

# グラフの表示

plt.show()

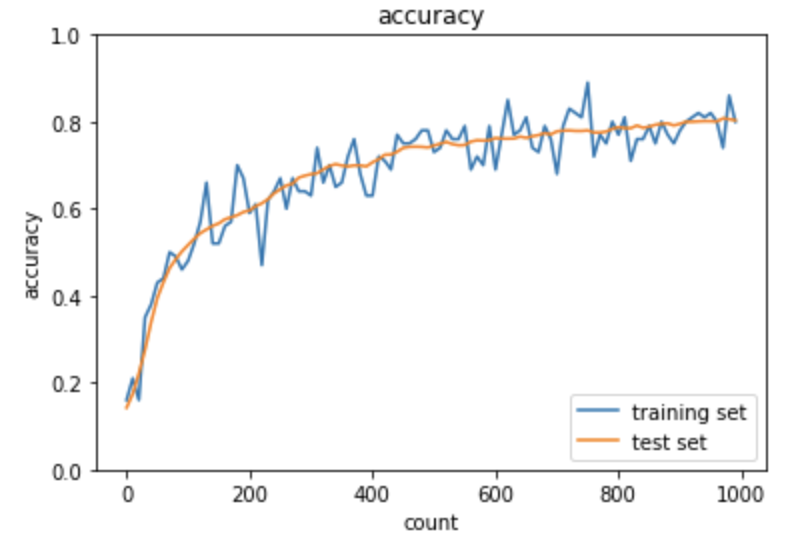

この時の実行結果のグラフは次の通り。

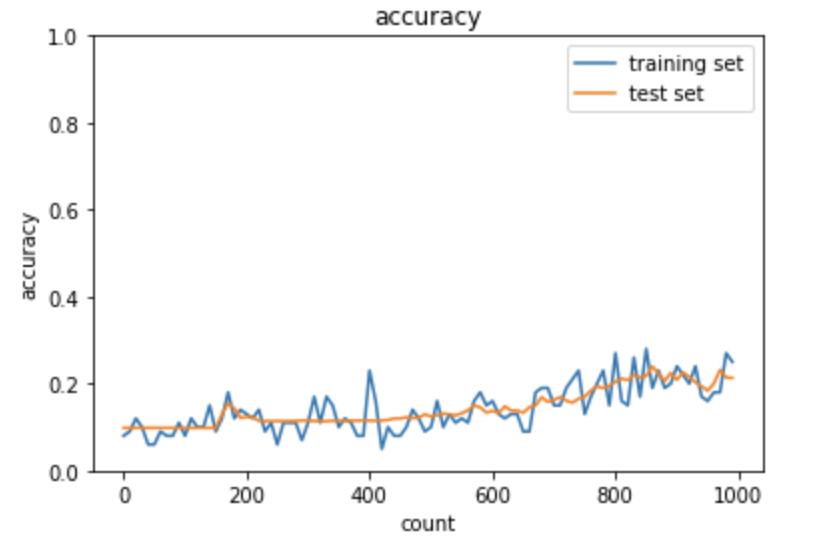

次に、上記のコード中の「use_batchnorm = False」として実行した時のグラフは次の通り。

「use_batchnorm」フラグは、MultiLayerNetクラス(multi_layer_net.pyに実装)に渡され、バッチ正規化を行っている。

上記のように、バッチ正規化により学習が安定して収束していることがわかる。