はじめに

これまで使っていたMacBook Proは2016年製、そろそろ買い替え時期と考えていた。MacBook Air(M4)を3月に購入した。ローカルでLLMを動かしたかったので、メモリは最大の32GBにした。4月から神田で働き始めたことや休日は色々な行事で忙しく、なかなか時間が取れなかったが、ようやくLM StudioでローカルLLMを試すことが出来た。

情報源

- Your local AI toolkit. - LM Studio公式サイト。

- MacでローカルLLMが動く!「LM Studio」で大規模言語モデルを使ってみよう - PC Watchの記事。

- LM Studioを使用してローカルでLLM環境を構築する - Zennのブログ記事。

インストール

ダウンロード・インストール

LM Studio公式サイトから、LM Studio for Mac(M series)をダウンロードする。Macでのアプリインストールの流儀に従って、「LM-Studio-0.3.16-8-arm64.dmg」をクリックして、アプリケーションフォルダにコピーすることでインストールする。

言語モデルをインストール

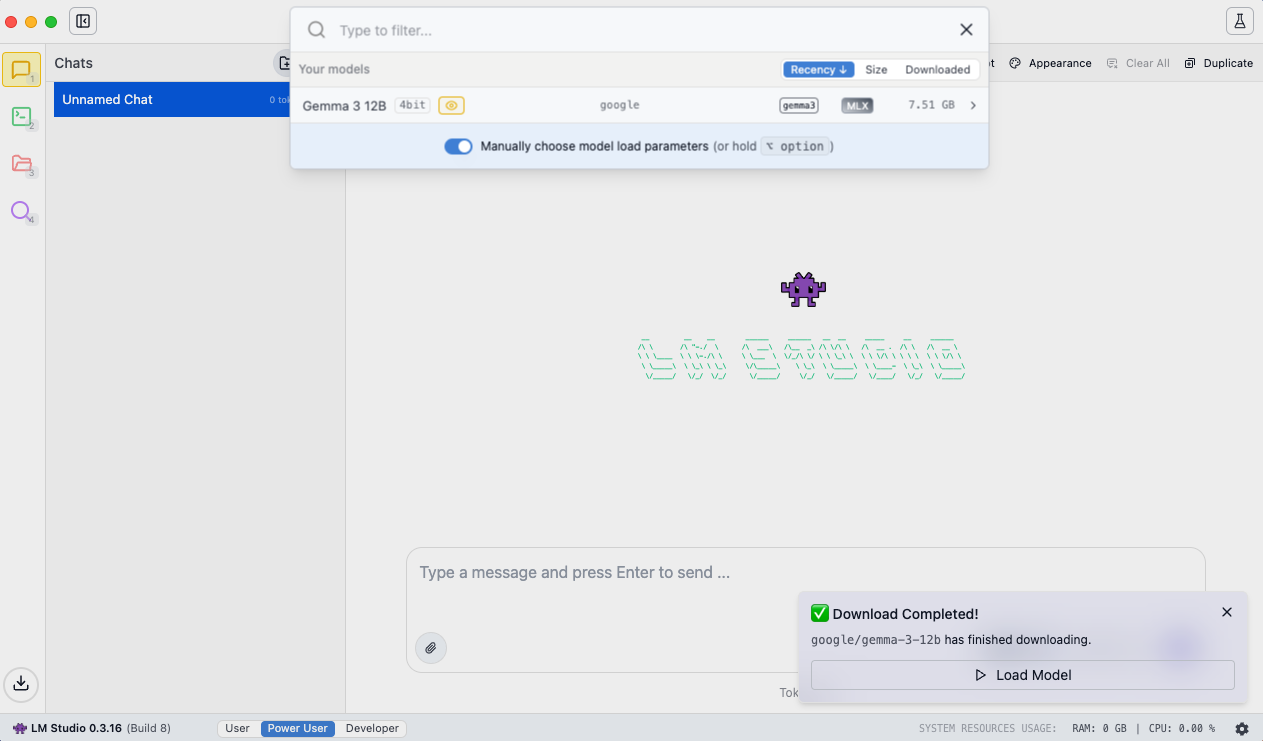

LM Studioを起動し、上部の「Select a model to load」をクリックすると、「gemma-3-12b」をダウンロード出来るようになっているので、ダウンロードする。

ダウンロードが完了したら、次のような画面となるので、右下の「Load Model」をクリックすると、gemma-3-12bが使えるようになる。

モデルを実行

Chatを開始

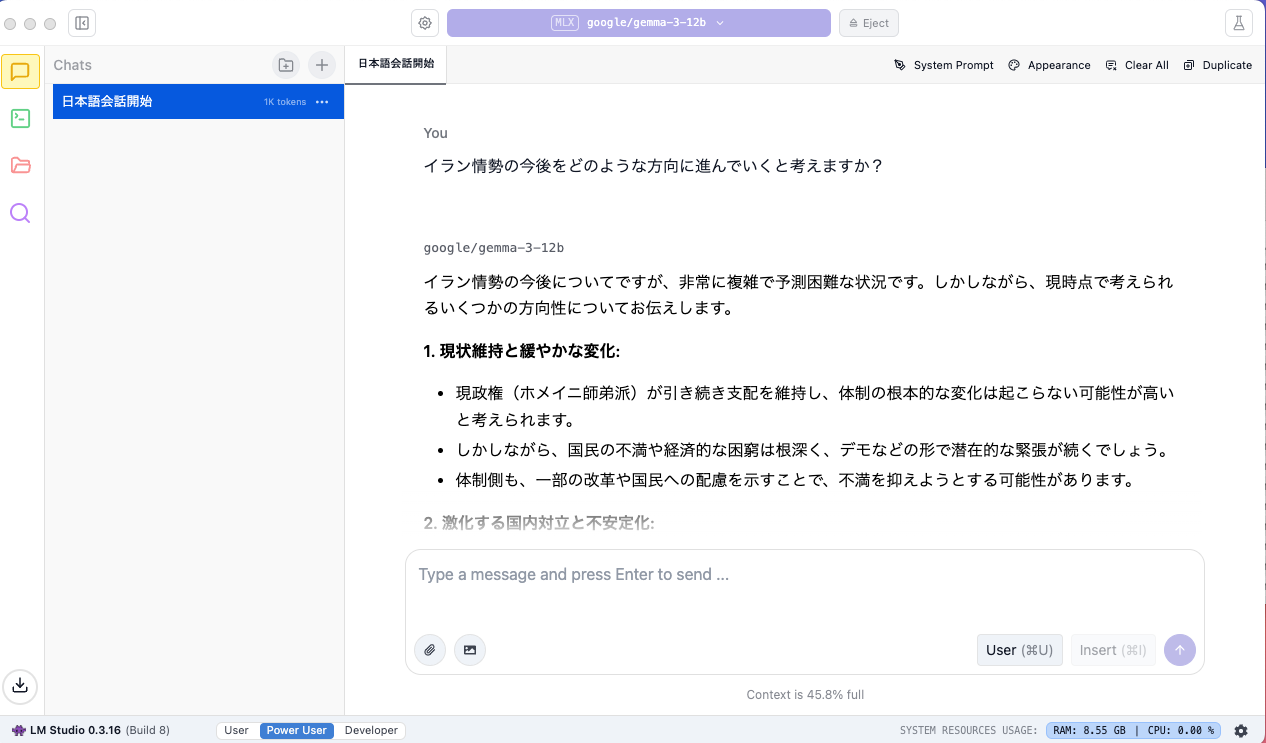

ここまでで、gemma-3-12bが使えるようになっているので会話開始。使っているモデルは、上部中央に表示される。今回の場合、「google/gemma-3-12b」と表示されている。

日本語での会話可能かと聞いたら、「日本語で会話できます。」との回答があったので、3つぐらい質問した。「焼きそばの美味しい作り方を教えて?」、「イラン情勢の今後をどうのような方向に進むと考えるか?」、「東京都議会選挙の結果をどのように予想しているか?」 以下は、イラン情勢についての回答の一部。全体は、4つの観点で各々3項目の回答、および最後に総合的な見通しの回答があった。TVワイドショーの下手なコメンテーターよりまともな回答。

今後について

質問から回答までの時間は想像より早かった。感覚的には、ChatGPT Plusでの回答までの時間と同程度の時間だった。ローカルLLMがMacBook Airというラップトップで、そこそこ満足できる品質(速度、回答内容)が得られることは、素晴らしい。

今後、MacBook AirでAIエージェントを体験してみようと思っている。